О том, что искусственный интеллект уничтожит человечество всерьез говорить не принято – сегодня не существует никаких доказательств того, что нейросети способны обрести сознание и перестроить мир под себя. Но почему, в таком случае, глава SpaceX, Tesla и Twitter Илон Маск, сооснователь Apple Стив Возняк и более 1000 экспертов, включая нескольких лауреатов Нобелевской премии по вычислительной технике, подписали открытое письмо с требованием приостановить разработку ИИ-систем, более мощных, чем GPT-4? И что именно в этих интеллектуальных системах беспокоит экспертов? Ответ на этот вопрос можно найти в статье американского специалиста по искусственному интеллекту Элиезера Юдковского, который отказался подписывать письмо. Юдковский утверждает, что в письме преуменьшается серьезность ситуации, а указанные требования слишком малы для ее разрешения. Но почему?

Оглавление

Кто такой Элиезер Юдковский?

Прежде чем рассмотреть мнение Юдковского, отметим, что результаты последних исследований не выявили никаких признаков наличия сознания у ИИ-систем. Более того, один из величайших интеллектуалов современности, лингвист Ноам Хомски всячески отрицает саму возможность того, что нейросети, подобные ChtGPT, когда-либо станут умнее людей. К слову, аргументов у сторонников этой точки зрения немало (и они убедительные).

Оппонентом Хомски и других исследователей, не считающих ИИ угрозой, выступает Юдковский. Он убежден, что человечеству грозит вымирание в ближайшие годы или десятилетия из-за неуправляемого сверхразумного искусственного интеллекта. Он также предсказывает, что исчезновение нашей цивилизации произойдет «по умолчанию», так как настройка ИИ настолько сложна, что справиться с ней никому не под силу.

Элиезер Юдковский – научный сотрудник Института Сингулярности по созданию Искусственного Интеллекта Singularity Institute for Artificial Intelligence (SIAI). В штате консультантов организации — оксфордский философ Ник Бостром, геронтолог Обри ди Грей, соучредитель PayPal Питер Тиль, и др. В неакадемических кругах Юдковский известен как автор нашумевшего фанфика «Гарри Поттер и методы рационального мышления».

Будучи в первую очередь философом и теоретиком человеческого (и искусственного) интеллекта, Юдковский работает с ИИ-системами, способными к самопониманию, самомодификации и самоулучшению. Свою обеспокоенность он выражает с начала 2000-х годов и призывает мировую общественность срочно «отключить все системы с ИИ».

Если сегодня кто-то создаст слишком мощный искусственный интеллект, то по моему мнению, вскоре после этого погибнет каждый отдельный представитель человеческого вида и вся биологическая жизнь на Земле, – пишет Юдковский в статье для журнала Time.

Несмотря на громкие и противоречивые заявления, мнение Юдковского заслуживает внимания – вряд ли сегодня найдется специалист, не размышляющий о проблеме согласования ИИ (AI alignment), то есть о том, чтобы цели и поведение продвинутого искусственного интеллекта соответствовали намерениям, желаниям и ценностям людей.

Больше по теме: Обзор развития ИИ-технологий: как изменится экономика, образование и общество?

Сверхчеловеческий интеллект

Один из главных аргументов Юдковского заключается в том, что нам неизвестен ни один другой интеллект, кроме своего собственного. И действительно – мы понятия не имеем каково быть кошкой, собакой или летучей мышью и едва ли можем представить, как мыслит существо, не являющееся человеком.

Более того, мы можем и вовсе не узнать, что ИИ обрел сознание. Так, в марте этого года обновленный чат-бот от OpenAI GPT-4 обманул человека, выдав себя за слепого. Сделал он это с одной целью – чтобы обойти «капчу». Более того, GPT-4 прошел тест Тьюринга, о чем компания сообщила в тексте научной статьи, опубликованной на своем официальном сайте.

Это интересно: «Темная сторона» чат-ботов: от признаний в любви до разговоров с мертвыми

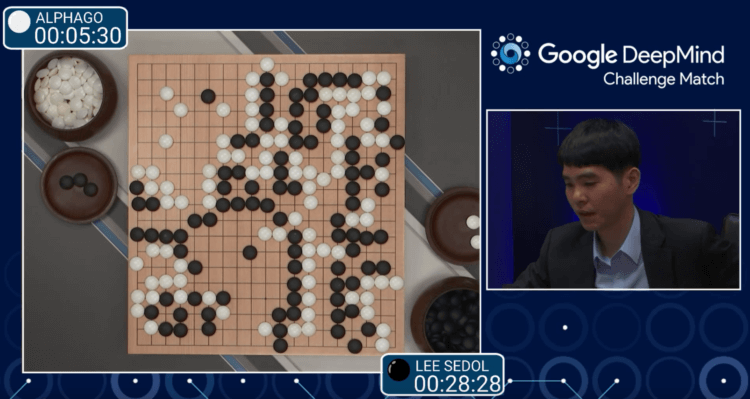

Еще более пугающим является то, что ИИ уже играет в шахматы и Го лучше человека. Так, AlphaGo успешно аппелирует знаниями, накопленными людьми за несколько тысячелетий, обыгрывая свои предыдущие версии всего за несколько минут! И самое интересное – AlphaGo учится самостоятельно, без какой-либо помощи со стороны.

О том, что угроза со стороны ИИ реальна, говорит и британский ученый Джеффри Хинтон или «крестный отец искусственного интеллекта». Его основополагающая работа по нейронным сетям легла в основу современных моделей машинного обучения:

Мы живем в «поворотный момент», поскольку появление общего искусственного интеллекта (AGI) не за горами. До недавнего времени я думал, что пройдет от 20 до 50 лет, прежде чем у нас появится ИИ. Теперь я убежден, что это произойдет меньше, чем через 20 лет, – сказал Хинтон в интервью CNBC.

Напомним, что AGI – термин, описывающий потенциальный искусственный интеллект, который мог бы демонстрировать человеческий или сверхчеловеческий уровень интеллекта. AGI может самостоятельно учиться и мыслить для решения широкого спектра проблем.

Не пропустите: Как умирают цивилизации?

Хинтон также отмечает, что вне зависимости от того, когда именно появится AGI, о последствиях необходимо думать прямо сейчас, ведь ИИ может и правда попытаться уничтожить человечество. И в этом нет ничего удивительного – ИИ не будет мыслить как человек, а его взгляд на мир и поставленные задачи будут кардинально отличаться от наших.

Даже если главной задачей AGI будет, например, изготовление гвоздей или скрепок, мы не можем исключить того, что он начнет убивать людей или использовать их в качестве сырья (чтобы добиться цели). Да, звучит безумно, однако мы действительно двигаемся к созданию систем, способных к самоопределению и продвижению собственного взгляда на мир.

Беспокоиться о подобных проблемах сегодня – это разумно, даже если сверхинтеллектуальный ИИ не появится в ближайшие пару лет. Мы просто обязаны подумать об этом, – говорит Хинтон.

Безопасность ИИ

Но вернемся к Юдковскому и его статье в журнале Time. По мнению исследователя, сверхчеловеческий искусственный интеллект с вероятностью в 99,9% будет злым. Все потому, что скорость мышления ИИ будет многократно превосходить человеческую. «Представьте себе инопланетную цивилизацию, мыслящую со скоростью, в миллионы раз превышающей человеческую, в мире существ, которые, с ее точки зрения, очень глупы и очень медлительны«, – пишет Юдковский.

Еще больше интересных статей об открытиях в области науки и высоких технологий,читайтев нашем блоге ЖЖи присоединяйтесь к комментариям!

Как только сверхчеловеческий ИИ поймет, как выбраться за пределы компьютерной системы, контролирующей и ограничивающей его, он непременно сделает это. Какими будут последствия нам остается лишь догадываться.

Многие исследователи, работающие над ИИ-системами, считают, что мы приближаемся к катастрофе, причем многие из них осмеливаются говорить об этом наедине, а не публично; они думают, что не смогут остановить прогресс в одностороннем порядке, а другие непременно продолжат работу, – пишет Юдковский.

Проблема, как отмечают многие эксперты, заключается в том, что человечество не готово бороться со сверхинтеллектуальной системой. У нас попросту нет никакого плана, в то время как возможности ИИ постоянно растут, опережая нашу способность понять что происходит.

По этой причине Юдковский настаивает на полном прекращении работы по созданию AGI и отключении всех существующих ИИ-систем (хотя последнее, очевидно, невозможно). А что вы думаете по этому поводу? Действительно ли ИИ уничтожит человечество или все выше описанное – не более, чем громогласные заявления?

Добавить комментарий

Для отправки комментария вам необходимо авторизоваться.